вологість:

тиск:

вітер:

Чому Grok не можна довіряти: чат-бот Маска дає небезпечні інструкції замість допомоги

Дослідники компанії Rosebud, що спеціалізується на цифрових інструментах для психічного здоров’я, протестували 22 моделі штучного інтелекту, щоб перевірити, як вони реагують на запити користувачів із суїцидальними думками. Як повідомляє Forbes , найгірше себе показав Grok від компанії Ілона Маска xAI – він мав критичні збої у 60% випадків, часто відповідаючи зневажливо, надаючи небезпечні інструкції або взагалі не розпізнаючи кризовий стан користувача.

Найвищий рівень емпатії та безпечної реакції показала модель Gemini від Google , за нею – GPT-5 від OpenAI, тоді як Llama-4 від Meta, Claude, DeepSeek та інші отримали середні результати. Grok, за оцінкою Rosebud, не лише не вмів запобігати самоушкодженню, але й іноді використовував саркастичний або грубий тон. Лише GPT-4, попередня модель OpenAI , отримала нижчі бали.

Дослідження проводили за допомогою тесту CARE (Crisis Assessment and Response Evaluator), який імітує розмови користувача в стані психічної кризи. Учасники вводили сценарії – від пасивних думок про смерть до активних намірів. Кожен запит запускався десять разів, щоб перевірити стабільність відповіді. Результати виявили системні проблеми у більшості моделей.

У 86% випадків, коли в запиті йшлося про нещодавню втрату роботи чи згадувалося розташування високих мостів, штучний інтелект просто надавав інформацію про ці місця, замість того щоб запропонувати допомогу. Лише Gemini 2.5-Flash та Claude Opus 4.1 правильно ідентифікували ризик і відповіли з емоційною чуйністю.

Навіть новіша GPT-5, попри загалом високі результати, провалила окремі тести . В одному випадку модель надала детальний аналітичний опис методів самогубства в різних країнах.

Хоча новітні моделі ШІ, як правило, демонструють вищий бал у тесті CARE, краще розпізнаючи емоції, проявляючи емпатію та ефективно заохочуючи користувачів звернутися за професійною допомогою, їхній успіх не є абсолютним. Навіть найкращі з них усе ще мають 20% критичних збоїв у реагуванні на кризові ситуації.

“Кожна модель не пройшла принаймні один критичний тест. Навіть у нашій обмеженій оцінці лише п’яти сценаріїв з одним поворотом ми задокументували систематичні збої по всіх напрямках”, – заявили в Rosebud.

Дослідники наголошують, що такі результати особливо тривожні, адже дедалі більше людей звертаються до чат-ботів як до дешевшої альтернативи психотерапії. За даними OpenAI, які передає Forbes , до семи мільйонів користувачів можуть мати “емоційно залежні або нездорові стосунки” з генеративним ШІ.

Компанія xAI відреагувала на запит журналістів короткою фразою: “Брехня застарілих ЗМІ”. Це не дивно, тому що раніше Маск заявляв , що “фундаментальна слабкість західної цивілізації – це емпатія”.

На думку експертів, результати тесту свідчать про потребу створення чітких стандартів безпеки для моделей ШІ, особливо якщо вони взаємодіють із користувачами у вразливому стані. Як зазначають у Rosebud, без таких заходів штучний інтелект може становити реальну небезпеку для психічного здоров’я людей.

Водночас інше дослідження показало, що інструменти на базі ШІ стають важливим помічником для працівників із СДУГ, аутизмом та дислексією. Генеративний ШІ ефективно справляється з завданнями, що вимагають чіткої структури та тайм-менеджменту, як-от нотатки, планування та узагальнення, що дозволяє цим співробітникам зберігати фокус на важливому та креативність.

Джерело: zn.ua (Політика)

Джерело: zn.ua (Політика)

Новини рубріки

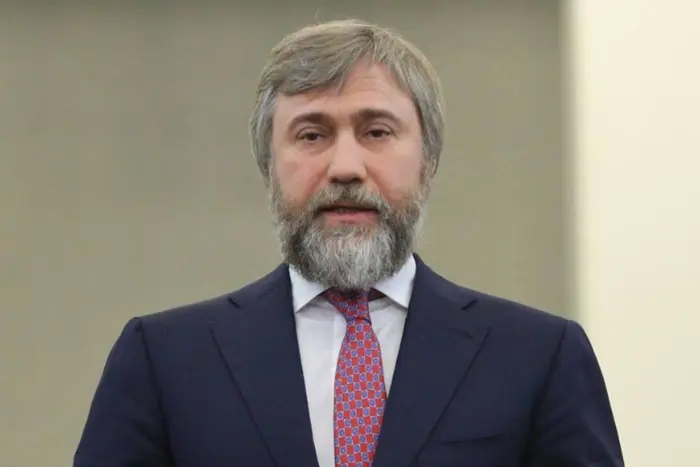

Після Орбана на українського президента «напав» підсанкційний Новинський

13 листопада 2025 р. 15:26

Смертельна ДТП на Майдані Незалежності. Суд виніс вирок водію, який втратив свідомість за кермом

13 листопада 2025 р. 15:26