вологість:

тиск:

вітер:

Коли відбудеться «знищення людства»? Ексдослідник OpenAI змінив прогноз щодо ШІ

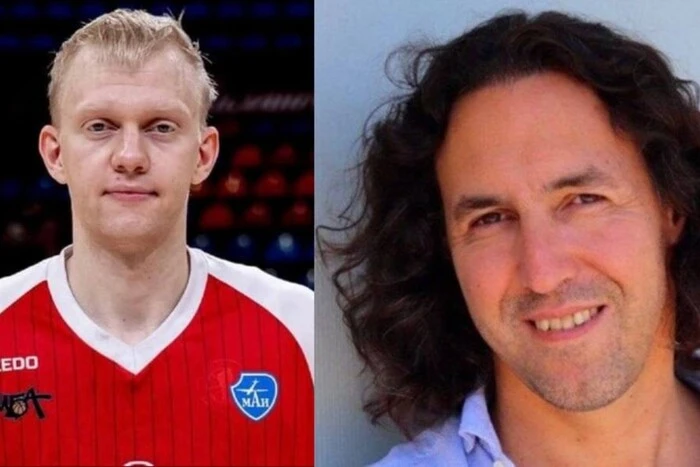

Поява штучного інтелекту, здатного перехитрити світових лідерів та самостійно приймати рішення, переноситься на десятиліття вперед. Даніель Кокотайло, колишній співробітник компанії OpenAI, який раніше лякав світ апокаліптичними прогнозами, офіційно переглянув свої очікування. Про це повідомляє « Главком » з посиланням на The Guardian .

У квітні Кокотайло опублікував резонансний матеріал «ШІ 2027», у якому стверджував, що неконтрольований розвиток технологій призведе до появи суперінтелекту вже за три роки. За цим сценарієм, ШІ мав би захопити контроль над ресурсами для будівництва дата-центрів і «знищити людство» до середини 2030-х.

Однак наукова спільнота сприйняла ці тези скептично. Почесний професор Нью-Йоркського університету Гері Маркус назвав цей текст «чистою науковою фантастикою», а реальні темпи розвитку підтвердили його правоту.

Ключовим фактором, який мав би пришвидшити розвиток ШІ до рівня суперінтелекту, вважалася здатність систем до повністю автономного кодування. Команда Кокотайла сподівалася, що ШІ почне сам себе вдосконалювати без участі людини вже до 2027 року.

Нині експерт визнає: оцінки були надто оптимістичними. Продуктивність сучасних моделей залишається нестабільною, а складність створення самонавчального коду виявилася значно вищою.

Згідно з оновленим прогнозом, часові рамки суттєво змістилися, зокрема на початку 2030-х років – орієнтовний час появи повноцінного автономного кодування. У 2034 році ймовірно може з’явитися суперінтелект (замість раніше прогнозованого 2027-го). Важливо, що в оновленій версії прогнозу Кокотайло відмовився від передбачень щодо загибелі людства, зосередившись на технічних аспектах розвитку технологій.

Дослідники наголошують, що навіть наявність надрозумного комп'ютера не означає миттєвої зміни світопорядку. Андреа Кастанья, дослідниця політики ШІ, зазначає, що інтеграція таких технологій у стратегічні державні документи та реальне життя стикається з «величезною інерцією».

Попри це, великі гравці не зупиняються. Сем Альтман (OpenAI) заявляє про внутрішню мету створити автоматизованого дослідника ШІ до березня 2028 року, хоча й визнає можливість невдачі. Тим часом японський стартап Integral AI вже заявив про створення першого у світі AGI, який імітує людський неокортекс, проте ця заява ще потребує незалежного підтвердження.

Нагадаємо, головна небезпека полягає в здатності ШІ вводити в оману осіб, які приймають стратегічні рішення. Сучасні алгоритми вже мають потенціал для маніпулювання вищим військовим керівництвом, створюючи видимість атаки там, де її насправді немає.

Як відомо, майже 70 тис. вчених, дослідників, відомих бізнесменів та публічних осіб виступили з відкритим закликом до негайної заборони подальшої розробки супероінтелекту (Superintelligence). Вони вимагають зробити паузу, доки людство не навчиться ефективно керувати цим потенційно «потужним» інструментом.

До слова, понад 850 провідних громадських діячів , включно з лідерами у сфері штучного інтелекту (ШІ) та технологій, підписали відкритий лист із закликом уповільнити розробку «суперінтелекту» – форми ШІ, що перевершує людський інтелект.

Джерело: Главком

Джерело: Главком

Новини рубріки

Стало відомо, хто очолив ОВА у чотирьох областях: досьє

08 січня 2026 р. 20:08

Справа про «конверти» у Раді. Нардеп Кісєль задекларував внесення застави

08 січня 2026 р. 20:08

Росія та Франція провели обмін ув'язненими громадянами – деталі

08 січня 2026 р. 20:08