вологість:

тиск:

вітер:

Якщо ШІ навчається на даних, створених ШІ, він швидко деградує

“Колапс моделі” — гіпотетичний сценарій , за якого штучний інтелект (ШІ) деградує через навчання на даних, що генеруються іншими моделями ШІ, загрожує зниженням якості його роботи та культурним різноманіттям в Інтернеті.

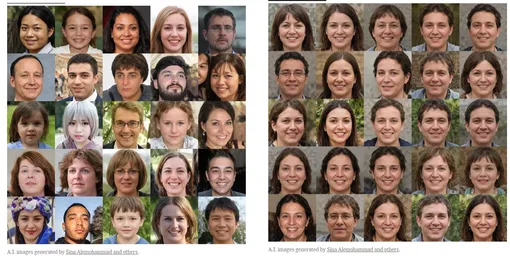

Обговорення “колапсу моделі”, яке набуло популярності в 2023 році, стосується ризику, що ШІ почне деградувати, якщо буде навчатися на даних, згенерованих іншими системами ШІ, а не на оригінальних людських даних. Сучасні ШІ системи, такі як GPT-3, потребують величезних обсягів високоякісних даних для свого навчання. Наприклад, для навчання GPT-3 було використано понад 650 мільярдів слів, отриманих з Інтернету, з яких близько 98% було відфільтровано. Цей процес підкреслює важливість якісних даних для створення ефективних моделей.

З появою широкодоступних генеративних систем ШІ, таких як ChatGPT, у 2022 році почало виникати питання: чи можна для навчання використовувати тільки дані, створені ШІ? Попри фінансові та етичні переваги такого підходу, дослідження показали, що ШІ, навчений на синтетичних даних, починає втрачати якість і різноманітність своїх реакцій. Цей процес подібний до “цифрового близькоспорідненого схрещування”, коли кожна наступна модель навчається на основі попередньої, що призводить до виродження поведінки моделі.

Загроза деградації моделі пов’язана з тим, що системи, навчені на даних, створених іншими системами ШІ, можуть стати менш ефективними, менш корисними і менш різноманітними у своїй поведінці. Попри те, що технологічні компанії вже витрачають значні ресурси на фільтрацію даних, відокремлення контенту, створеного ШІ, стає дедалі складнішим завданням. У перспективі це може призвести до зниження якості нових моделей, оскільки відфільтрувати синтетичні дані стає все важче.

Існують побоювання, що джерела високоякісних людських даних можуть вичерпатися вже до 2026 року. Ця загроза стимулює компанії, такі як OpenAI, укладати партнерські угоди з власниками великих колекцій даних, щоб зберегти доступ до оригінальних людських даних. Однак катастрофічний сценарій, у якому моделі повністю деградують, здається перебільшеним. Швидше за все, людські та синтетичні дані будуть використовуватися паралельно, що знизить ризик колапсу моделей.

Однак реальні загрози все ж існують. По-перше, використання синтетичних даних може призвести до зниження активності в онлайн-спільнотах, як це сталося на платформі StackOverflow після появи ChatGPT. По-друге, надмірна кількість контенту, створеного ШІ, може ускладнити доступ до якісного, автентичного контенту в Інтернеті. Також виникає ризик втрати соціокультурного різноманіття, оскільки однорідний синтетичний контент може витіснити унікальні культурні погляди та практики.

Таким чином, питання “колапсу моделі” висвітлює важливість захисту людських даних і взаємодії між людьми в цифровому просторі. Попри певні перебільшення щодо катастрофічних наслідків, потенційні ризики потребують серйозної уваги з боку дослідників, розробників та регулюючих органів, щоб забезпечити стійкий розвиток технологій ШІ.

Джерело: cikavosti.com (Технології)

Джерело: cikavosti.com (Технології)

Новини рубріки

Найбільша пустеля на Землі страждає від сильних злив: чому

16 вересня 2024 р. 17:21

Google може додати синхронізацію сповіщень між пристроями в Android 15

16 вересня 2024 р. 17:10